Transformer Modelle und Deep Learning

Video: .mp4 (1280x720, 30 fps(r)) | Audio: aac, 48000 Hz, 2ch | Size: 1.13 GB

Genre: eLearning Video | Duration: 14 lectures (1 hour, 57 mins) | Language: Deutsch

Video: .mp4 (1280x720, 30 fps(r)) | Audio: aac, 48000 Hz, 2ch | Size: 1.13 GB

Genre: eLearning Video | Duration: 14 lectures (1 hour, 57 mins) | Language: Deutsch

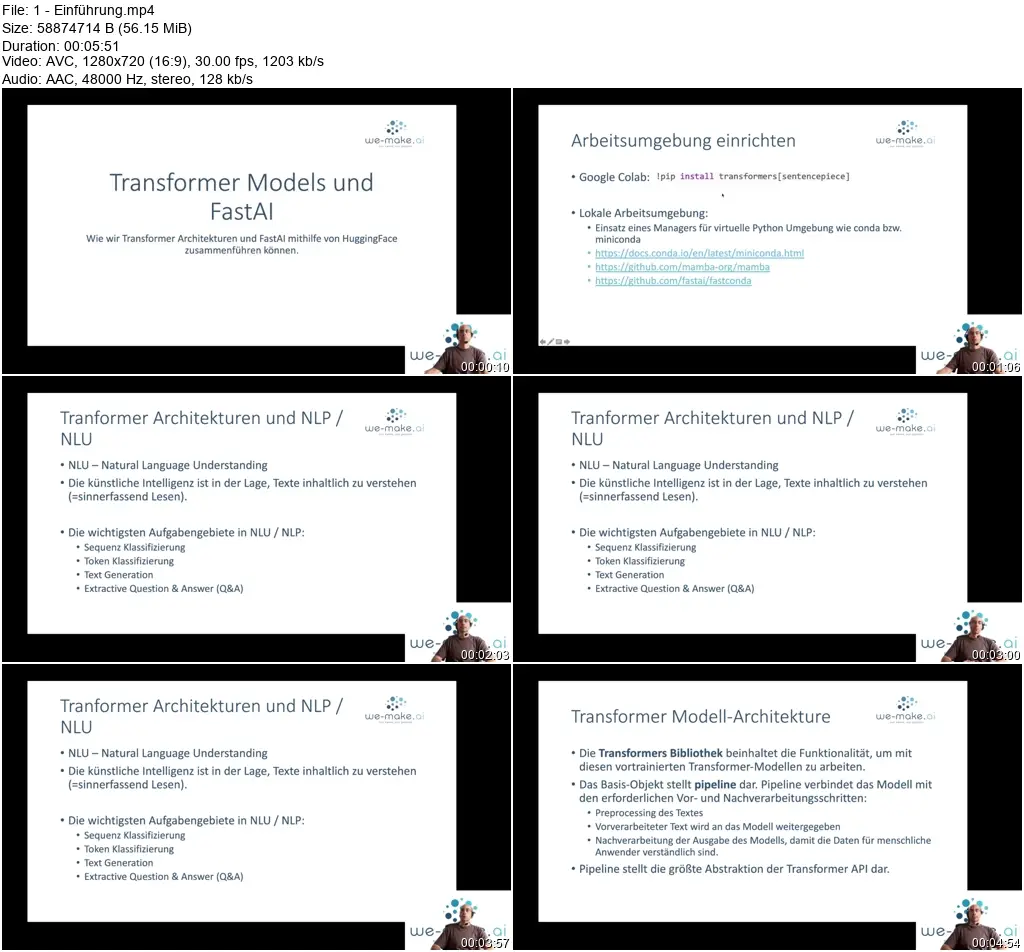

Integration von Encoder-Decoder Modellen mithilfe von Hugging Face und Fastai für Natural Language Understanding

What you'll learn

Du lernst, wie du Transformer Modelle wie BERT oder GPT2 für NLP Aufgaben verwendest.

Transfer Learning mithilfe von vortrainierten Modell im Deep Learning umsetzen

Wie kann künstliche Intelligenz mithilfe von Encoder / Decoder Modellen Texte generieren?

Was sind Transfomer Modell Architekturen?

Wie können wir die fastai Bibliothek einsetzen, um Transformer Modell Architekturen zu integrieren?

Der Hugging Face Modell Zoo

Eigene vortrainierten Modelle via Hugging Face Hub zu Verfügung stellen.

Course content

7 sections • 14 lectures • 1h 57m total length

Requirements

Grundlegendes Verständnis für Deep Learning Architekturen

Basisprogrammierkenntnisse in Python

Basiskenntnisse aus PyTorch / fastai

Description

Dieser Kurs beschäftigt sich mit dem Thema Encoder-Decoder-Modellarchitekturen im Deep Learning und darauf basierenden Anwendungsfällen im Bereich Natural Language Understanding.

Wir besprechen, wie Encoder-Decoder Modelle (insbesondere Transformer Modelle wie GPT2 oder BERT-Architekturen) aufgebaut sind und welche Schritte während des Trainings eines solchen Modells ablaufen.

Der große Nutzen dieser vortrainierten Modellarchitekturen besteht in der Anwendung des Transfer-Learning Konzepts. Das bedeutet, wir können uns riesige, vortrainierte Modellarchitekturen zu Nutze machen und mit relativ wenig Aufwand für unseren konkreten Anwendungsfall trainieren.

Wie können wir mittel one-shot-classification Texte einer bestimmten Kategorie zuordnen?

Wie integrieren wir Modelle aus dem Hugging Face Projekt in unsere eigenen Deep Learning Projekt auf Basis der fastai Bibliothek?

Neben dem theoretischen Input entwickeln wir anhand von Jupyther Notebooks Anwendungsbeispiele und gehen den implementierten Code unserer KI-Anwendungen Schritt für Schritt gemeinsam durch.

Lernziele Transformer Modelle, Deep Learning und fastai

Folgende Lernziele verfolgen wir mit dem Kurs Transformer Modelle (Encoder/Decoder Architekturen) und Deep Learning:

- Du lernst das erforderliche theoretische Basiswissen, um Transformer Modellarchitekturen im Deep Learning zu verstehen.

- Du kannst das Funktionsprinzip von Transformer Modellen wie BERT oder GPT2 verstehen.

- Du lernst, wie du Transformer Modelle in fastai Projekt integrieren kannst

- Du lernst verschiedene Bibliotheken wie `Blurr` oder `FastHugs` kennen.

- Mithilfe von Bibliotheken integrieren wir vortrainierte Transformermodelle mittels Hugging-Face und fastai Framework.

"Transformers (früher bekannt als pytorch-transformers und pytorch-pretrained-bert) bietet Allzweckarchitekturen (BERT, GPT-2, RoBERTa, XLM, DistilBert, XLNet…) für Natural Language Understanding (NLU) und Natural Language Generation (NLG) mit über 32+ vortrainierten Modellen in über 100 Sprachen und umfassender Interoperabilität zwischen Jax, PyTorch und TensorFlow." (Quelle: huggingface)

Wir zeigen in diesem Kurs, wie wir Transformer (Encoder / Decoder) Modelle aus dem Hugging Face Model Zoo mithilfe von verschiedenen Bibliotheken in das fastai Framework integrieren können.

Insbesondere die Erfolge von künstlicher Intelligenz und Deep Learning im Bereich der Textanalyse und Textgenerierung ist den Transformer Modellarchitekturen zu verdanken. Modellnamen wie BERT oder GPT2 sind wohl allen ein Begriff.

In diesem Kurs präsentieren wir verschiedene Bibliotheken und Projekte, die es uns ermöglichen, vortrainierte Modelle via Hugging Face Model Hub gemeinsam mit der fastai Bibliothek einsetzen können.

Das Transformer Modell stellt im Wesentlichen eine Serie von hintereinander verknüpften Encodern dar. Ein Embedding Layer ist für die Tranformation der Eingabedaten in eine Vektorrepräsentation verantwortlich. Die Weights dieser Schicht werden während des Trainings angepasst.

Nachdem die Eingabedaten durch den Embedding Layer in eine Vektorrepräsentation übergeführt worden sind, erstellt das Modell eine interne Repräsentation. Der Decoding Layer ist dann wiederum für die Überführung der internen Repräsentation im Modell in die Ergebnisschicht verantwortlich.

Unterschiedliche Längen der Eingabesequenzen werden durch Padding-Mechanismen angepasst.

Zusätzlich wurden in den Encoder / Decoder Modellen Attention Layer eingeführt.

Who this course is for:

Du lernst in diesem Kurs, wie du vortrainierte Modelle von HuggingFace nun auch mit dem fastai Deep Learning Framework einsetzen kannst.